DAVID CONTRE GOLIATH

3 mars 2014

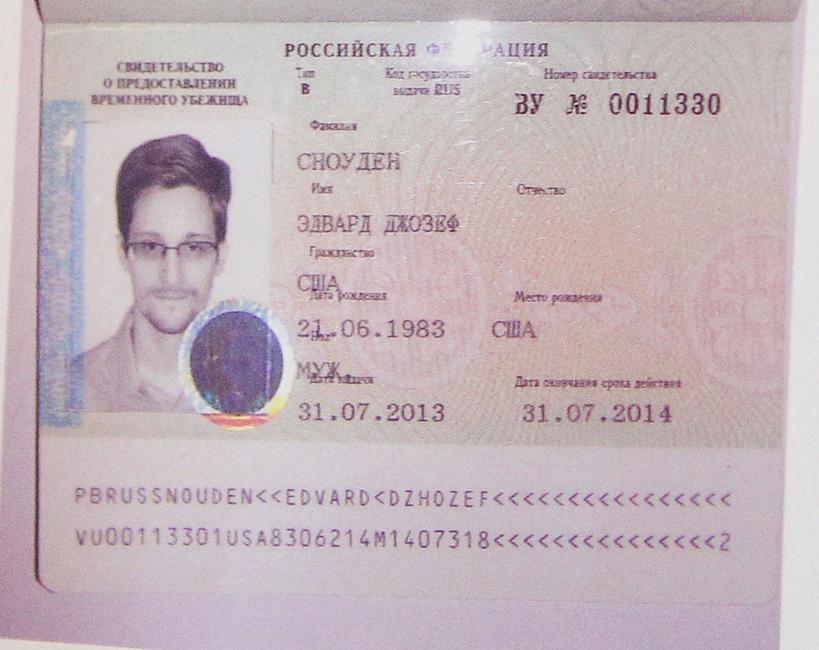

Snowden finalement plus fort que la NSA ? Espionnage et surveillance : le match humain contre électronique

Les agences de renseignement craignent de plus en plus un "effet Snowden", où un agent s'enfuirait avec un CD-Rom comprenant des milliers de données. L'électronique est-il devenu le talon d'Achille du renseignement ?

Alain Chouet est un ancien officier de renseignement français.

Il a été chef du service de renseignement de sécurité de la DGSE de 2000 à 2002.

Alain Chouet est l'auteur de plusieurs ouvrages sur l’islam et le terrorisme. Son dernier livre, "Au coeur des services spéciaux : La menace islamiste : Fausses pistes et vrais dangers", est paru chez La Decouverte en 2011.

Populaires

Alain Chouet est un ancien officier de renseignement français.

Il a été chef du service de renseignement de sécurité de la DGSE de 2000 à 2002.

Alain Chouet est l'auteur de plusieurs ouvrages sur l’islam et le terrorisme. Son dernier livre, "Au coeur des services spéciaux : La menace islamiste : Fausses pistes et vrais dangers", est paru chez La Decouverte en 2011.